Ollama

Bundle 包含支持与 Langflow 特定第三方集成的自定义组件。

本页面描述 Ollama bundle 中可用的组件。

有关 Ollama 组件使用的 Ollama 功能的更多信息,请参阅 Ollama 文档。

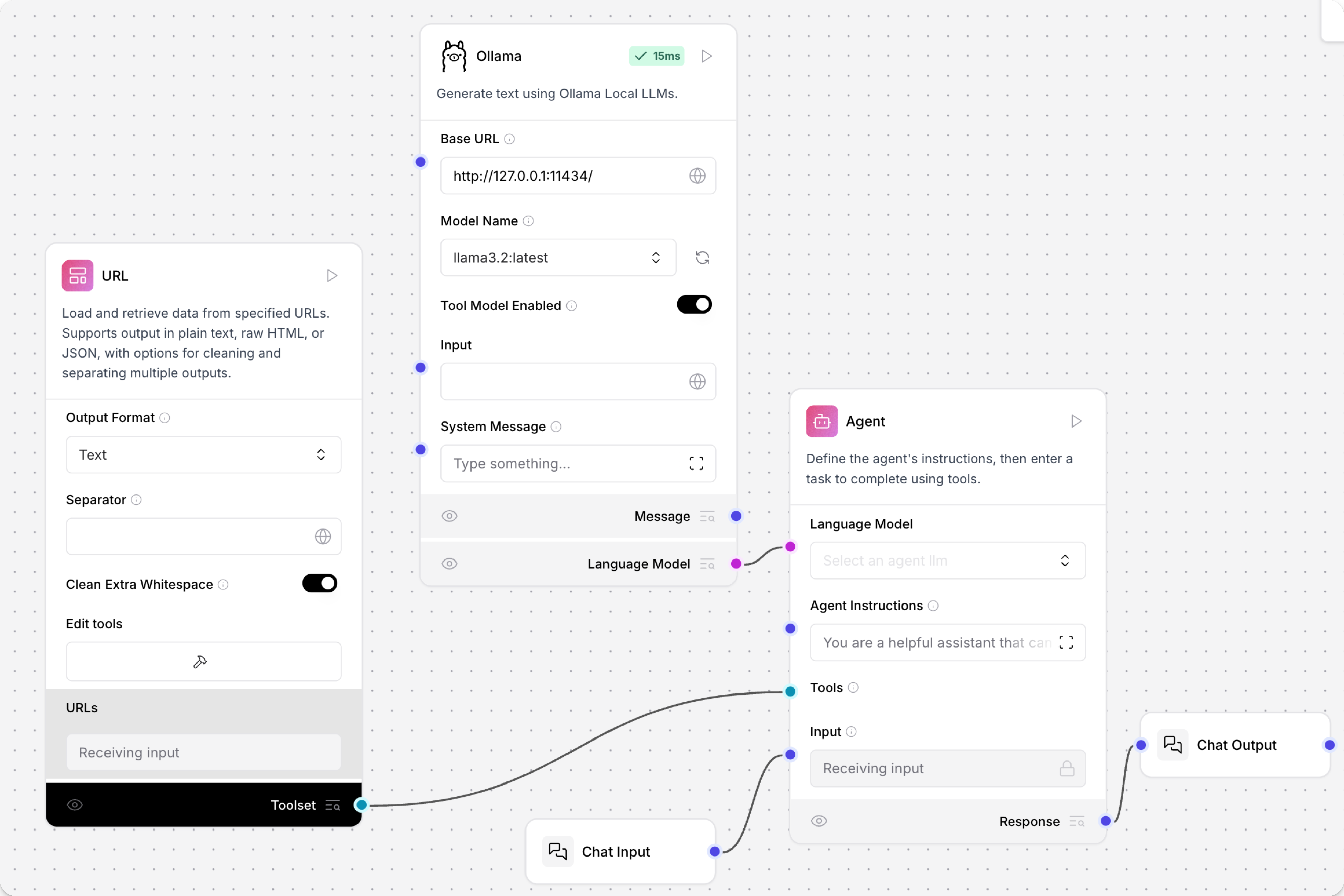

Ollama 文本生成

此组件使用 Ollama 的语言模型生成文本。

要在流中使用 Ollama �组件,请将 Langflow 连接到本地运行的 Ollama 服务器并选择模型:

-

将 Ollama 组件添加到您的流中。

-

在 Base URL 字段中,输入本地运行的 Ollama 服务器的地址。

此值设置为 Ollama 中的

OLLAMA_HOST环境变量。 默认基础 URL 是http://127.0.0.1:11434。 -

建立连接后,在 Model Name 字段中选择一个模型,例如

llama3.2:latest。要刷新服务器的模型列表,请点击 Refresh。

-

可选:要配置其他参数(如温度或最大令牌数),请点击组件标题菜单中的 Controls。

-

根据您想要如何使用模型,将 Ollama 组件连接到流中的其他组件。

语言模型组件��可以输出 Model Response (

Message) 或 Language Model (LanguageModel)。当您想要使用 Ollama 模型作为其他 LLM 驱动组件(如 Language Model 或 Smart Function 组件)的 LLM 时,请使用 Language Model 输出。有关更多信息,请参阅 Language Model 组件。在以下示例中,流使用

LanguageModel输出将 Ollama 模型用作 Agent 组件的 LLM。

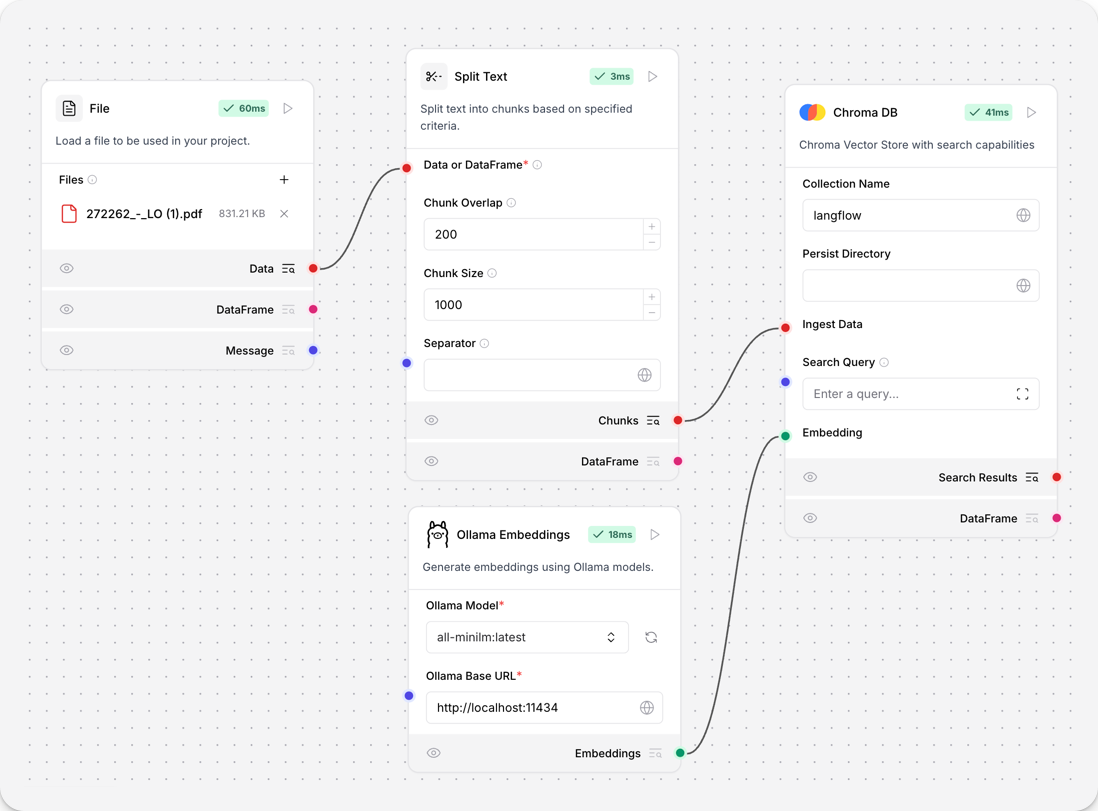

Ollama Embeddings

Ollama Embeddings 组件使用 Ollama 嵌入模型生成嵌入。

要在流中使用此组件,请将 Langflow 连接到本地运行的 Ollama 服务器并选择嵌入模型:

-

将 Ollama Embeddings 组件添加到您的流中。

-

在 Ollama Base URL 字段中,输入本地运行的 Ollama 服务器的地址。

此值设置为 Ollama 中的

OLLAMA_HOST环境变量。 默认基础 URL 是http://127.0.0.1:11434。 -

建立连接后,在 Ollama Model 字段中选择一个模型,例如

all-minilm:latest。要刷新服务器的模型列表,请点击 Refresh。

-

可选:要配置其他参数(如温度或最大令牌数),请点击组件标题菜单中的 Controls。 可用参数取决于所选模型。

-

将 Ollama Embeddings 组件连接到流中的其他组件。 有关在流中使用嵌入模型组件的更多信息,请参阅 Embedding Model 组件。

此示例连接 Ollama Embeddings 组件为从 PDF 文件中提取的文本块生成嵌入,然后将嵌入和块存储在 Chroma DB 向量存储中。